谈一谈A/B test

到底是方案A好呢还是方案B好呢,那我们测试一下,这就是A/B test(A/B测试),淡化经验主义,摒弃拍脑袋决策,强调假设验证科学决策。A/B test是一套方法论,没有应用领域上的局限,在产品、设计、投放、运营等日常工作中都可以应用。

从名字就能看出来,A/B test的核心是对比,通过控制变量,进行对比实验,然后分析得出结论。

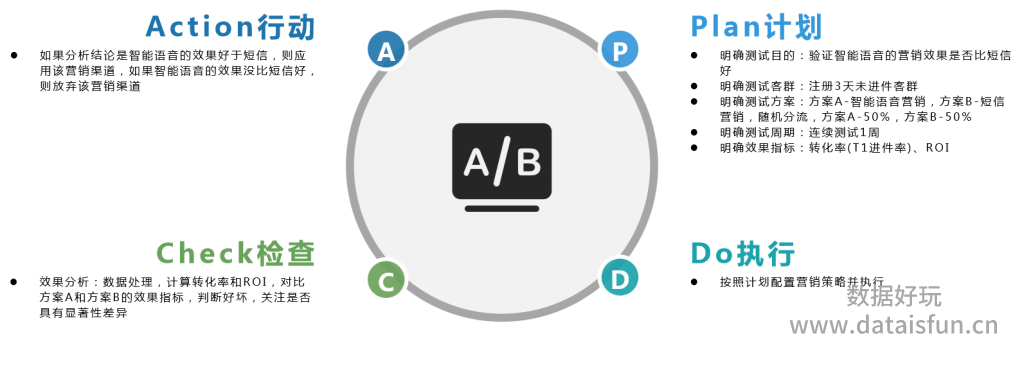

我们以实例说明嵌入PDCA循环的A/B test大致流程:

需要强调的几个点:

1. 对照组(控制组)

控制你的控制组,确保你的实验组和控制组(对照组)之间的差异只有你想要有的差异,比如你想测试优惠券的效果,实验组设置为:发优惠券并发营销短信,对照组设置为:什么都不做,其实最后无法确定客户是被优惠券促动的还是被短信促动的,对照组更应该设置为:不发优惠券但发营销短信,或者选择设置2个对照组,对照组1设置为:不发优惠券但发营销短信,对照组2设置为:什么都不做。

2. 客群分流

依据客群总量和个人习惯决定随机分流比例,原则是尽可能避免随机误差的影响,假设我们只需要分两组,在客群总量足够的时候,一般按一九开或者二八开分流,在客群总量不多的时候,最好按五五开分流。当然,业务上允许的话,最好直接按五五开分流,一是各组受随机误差或异常客户的影响是一致的,二是方便后续的效果分析。

3. 测试周期

一般是要连续测试一段时间的,因为在后续效果分析的时候,除了要看总体数据的效果,还要看每天的效果,如果实验组总体效果好于对照组,且对比每天的效果大部分时间也都是实验组好于对照组,这样更能说明实验组好于对照组。

4. 效果指标

效果指标一般都是看转化率或ROI(或者费率),具体的明确的指标则根据业务和客群而定。

5. 效果分析

累积一定数据后,就可以进行效果分析了,主要就是计算实验组和对照组的效果指标,然后进行对比分析。

对转化率而言,除了看转化率是否具有差异之外,还要通过假设检验观察转化率是否具有显著性差异,避免随机误差影响结论判断,假设检验可以借助A/B test计算器完成,比如:

以我个人的经验来说,假设检验不是必须的,如果连续测试两周,每天的效果都是实验组好于对照组,只是转化率差的没那么多,假设检验认为效果没有差异,但业务上可以认为实验组效果好于对照组。

对ROI而言,要注意ROI计算所涉及的成本和回报在我们的业务场景下分别是什么,然后再计算。像产品功能、页面等的A/B test可能不需要计算ROI,因为成本是一样的,但投放和营销的策略不同其成本差异较大,还是要看ROI的。

“做增长就是做测试”,A/B test的重要性已经无需证明了,多想想多测测,可能就找到路了。

原创文章,转载请务必注明出处并留下原文链接。

很好